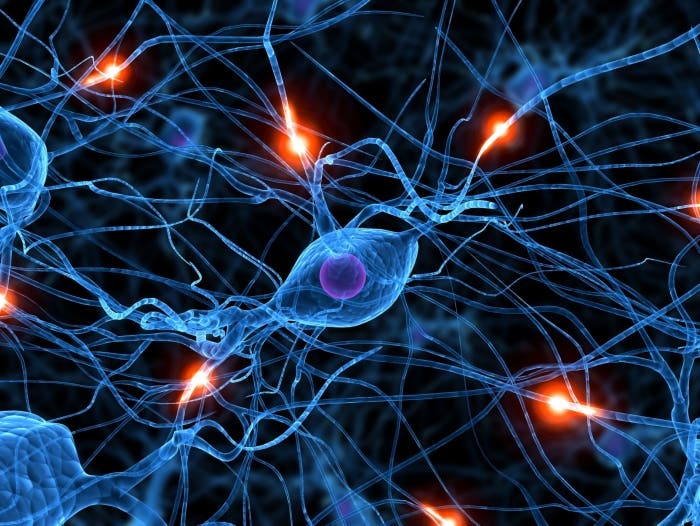

El cerebro humano lo forman 33.000 millones de neuronas, 10.000 conexiones sinápticas, pesa aproximadamente 1,5 Kg, y consume una energía menor que una bombilla de 100W. Es el responsable de procesar la información proveniente de los sentidos y de coordinar el movimiento de los músculos. En él se ubican todas las funciones cognitivas, el aprendizaje y la retención de la memoria.

Mucho se ha avanzado desde que el médico español Ramón y Cajal ganase el premio Nobel de medicina en 1906, por caracterizar la estructura y conexiones de las células nerviosas.

Los avances en neurociencia han sido enormes durante el siglo XX y principios del XXI, gracias al esfuerzo de científicos de todo el mundo. El desarrollo de las tecnologías de secuenciamiento y microscopía llevan la observación del cerebro a una dimensión sin precedentes. Sin embargo, la dispersión de organismos y fundaciones que se dedican al titánico esfuerzo de comprender el funcionamiento del cerebro, ha llevado también a una dispersión de los datos y resultados obtenidos. Esos datos describen diferentes áreas del cerebro, de diferentes especies y a diferentes niveles evolutivos.

Se hace, por tanto, necesario integrar todos los datos que ahora son como las piezas de un puzle de muchas dimensiones que se encontrasen diseminadas entre los laboratorios de investigación de todo el mundo. Los avances en la supercomputación, las tecnologías en la nube e Internet abren ahora la posibilidad de que esa integración sea posible. Hoy se pueden crear simulaciones de modelos cerebrales con un nivel de detalle, a nivel biológico, que hace unos años era casi una quimera.

Como respuesta a este desafío, el Proyecto Cerebro Humano se constituyó en el seno de la Unión Europea a partir de un informe, concluido en 2012 por un equipo de cerca de trescientos expertos en medicina, neurociencia y computación, entre los que se encontraban profesores de la Universidad Politécnica de Madrid.

En sus conclusiones, resumieron el objetivo del proyecto:

El Proyecto Cerebro Humano debería asentar los cimientos técnicos para un nuevo modelo de investigación del cerebro basada en Tecnologías de Información y Comunicación (ICT), que conduzcan a una integración entre datos y conocimiento de diferentes disciplinas y catalicen un esfuerzo comunitario para lograr un nuevo entendimiento del cerebro, nuevos tratamientos para las enfermedades cerebrales y nuevas tecnologías de computación basadas en el funcionamiento del cerebro.

Como consecuencia de este objetivo, el proyecto persigue obtener datos que permitan construir modelos cerebrales, identificar los principios matemáticos que rigen el funcionamiento del cerebro así como su papel en la capacidad del mismo de almacenar información, construir la plataforma ICT que acelere las investigaciones de los científicos y la más importante: las aplicaciones en neurociencia, medicina y tecnologías de computación. Sobre las aplicaciones en neurociencia y medicina la importancia es más que evidente, quizá no tanto en el caso del desarrollo de nuevas tecnologías de computación.

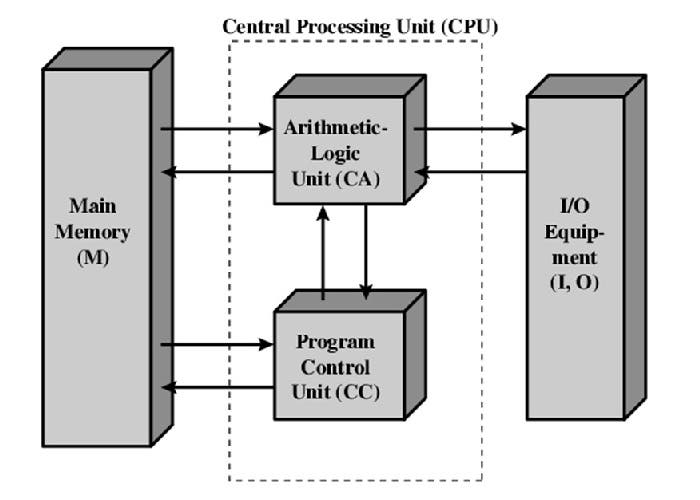

Los ordenadores tradicionales están basados en la arquitectura von Neumann y constituidos por circuitos digitales que operan con lógica binaria, es decir, que sólo tratan los datos en términos de verdadero o falso y que requieren una complejidad que tiende a crecer de manera exponencial en función del tamaño del resultado de cálculo requerido. Dada su construcción tienen muchos puntos que les hacen vulnerables al fallo, de tal forma que si dicho fallo se produce (por ejemplo, la CPU), el computador deja de funcionar por completo. Además, los superordenadores tienen un consumo eléctrico del orden de megavatios (a lo que se añade el consumo de los sistemas de aire acondicionado necesarios para refrigerarlos).

La ventaja de las arquitecturas neuromórficas se centra en varios factores:

- Potencial para conseguir (a semejanza de los humanos) inteligencia basada en dispositivos con baja fiabilidad, a modo de tejido neuronal.

- Sus estrategias para manejar anomalías, poniendo énfasis no sólo en la tolerancia al ruido y fallos, sino en el uso del ruido para incrementar su efectividad.

- Su potencial para funcionar con muy poca energía.

Los sistemas neuromórficos muestran un incremento más gradual de su complejidad, por lo que al nivel de tareas de cálculo análogas a las humanas, estos sistemas tienen el potencial para ser superiores a las máquinas von Neumann y son capaces de trabajar con lógica difusa: quizás, podría, etc…

Las aplicaciones de un dispositivo de estas características son tantas como pueda imaginarse, sin olvidar el aspecto del consumo de potencia, que como se ha indicado, sería del orden de cientos de vatios (frente a megavatios en su equivalente convencional).

El proyecto, que tendrá un coste aproximado de 1.200 millones de euros, se ha definido en tres fases durante un período de diez años. Durante los dos primeros años, el foco principal será la construcción de las versiones iniciales de la plataforma ICT, así como la introducción de datos seleccionados. España también contribuirá en aportar potencia de cálculo con la participación del Centro Nacional de Supercomputación en simulaciones a nivel molecular. En los siguientes cinco años, se buscará la generación de nuevos datos y añadir capacidad a la plataforma. En los tres años finales, el conocimiento y capacidades adquiridos deberán conducir a la auto-sostenibilidad financiera del proyecto que le dé continuidad.

Los descubrimientos que se produzcan en los próximos años pueden ser tan sorprendentes como los procedentes del acelerador de partículas del CERN. Si las expectativas se cumplen, los avances tanto en neurociencia como en tecnología informática supondrán una revolución que cambiará tanto la medicina como la industria y hará posible la tan buscada inteligencia artificial, llevando a la humanidad a transformaciones que ahora parecen ciencia ficción.

¿Crees que las máquinas llegarán a pensar algún día? ¿Se cumplirán las visiones catastrofistas de la ciencia ficción?