El camino de la fotografía comenzó hace 200 años, pero el ser humano ha sentido la necesidad durante muchísimos más años de plasmar lo que veía a través del dibujo. El deseo de inmortalizar paisajes o personas ha estado ahí durante mucho tiempo, y gracias a la propia luz del sol pudo hacerse realidad.

Hoy en día casi todos tenemos una cámara a mano, ya sea la de nuestros móviles o una cámara compacta, y la mayoría de ellas funcionan de un modo similar obviando características especiales. Hasta hace poco se conseguía inmortalizar una escena grabando la luz en un papel o película, pero actualmente el proceso consiste en convertir la luz en bits y bytes.

Primero hay que medir la cantidad de luz

La lente de una cámara esta formada por múltiples componentes ópticos, que se encargan de capturar, dirigir y enfocar la luz de forma adecuada. Cuando ajustamos el enfoque de nuestra cámara, realmente lo que está ocurriendo es que es las diferentes partes de dicha lente se mueve físicamente. Para haceros una idea general, en la imagen superior podéis ver las diferentes piezas que la componen.

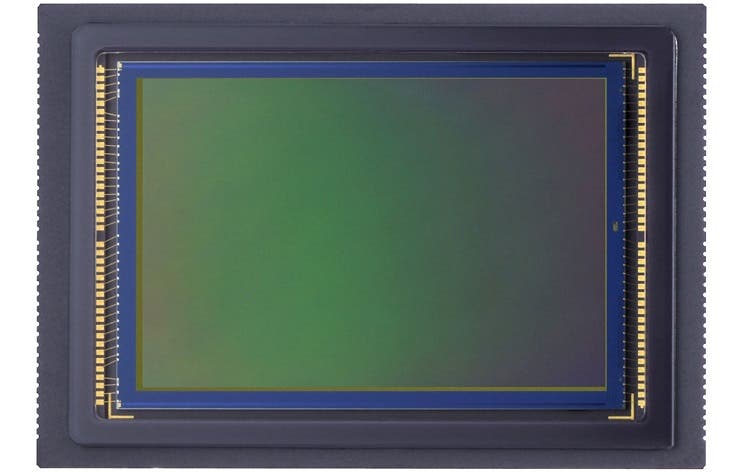

Todo comienza realmente con el sensor de imagen, y aunque hay diferentes tipos, el más extendido es el sensor CMOS. Este sensor se encarga de convertir la luz/fotones que recibe en señales eléctricas. Podríamos decir que este sensor es el equivalente a la retina en nuestros ojos.

Realmente un sensor de imagen consiste en una agrupación de muchísimos elementos fotosensibles (denominados píxeles) dispuestos en un gran rectángulo. Imaginad una matriz rectangular de 2 dimensiones con millones de elementos, o para quienes no sepáis qué es una matriz, imaginad un rectángulo gigante con una cuadrícula en su interior de millones de cuadrados.

Cuando los fotones llegan al fotodiodo del sensor de imagen, estos van cargando cada uno de los píxeles (que equivalen a los cuadrados que decía antes) hasta que coincida con el nivel de los fotones y por tanto, de la intensidad de la luz. Es decir, que lo primero de todo en una fotografía es capturar la cantidad de luz exacta en cada uno de los millones de píxeles del sensor.

Aquí también entra en juego el obturador, que permitirá que pase más o menos luz a la lente según su apertura, durante un tiempo determinado indicado por la velocidad del mismo. Hay distintos tipos de obturador, aunque en la telefonía móvil no se suele dar la opción de controlarlo, a excepción de casos concretos como el Nokia Lumia 1020.

Ahora se añade el color

Antes de nada, hay que dejar claro que el color por sí mismo no existe, no existe fuera de nuestra percepción, el color es una percepción visual y nada más. Hace falta una fuente de luz y algo que refleje dicha luz para poder apreciar el color de un objeto. En una habitación sin ningún tipo de luz no existe el color, no se trata de que no veamos nada porque está oscuro.

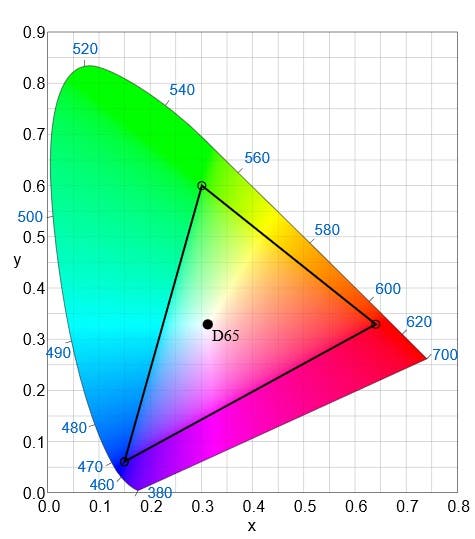

Para representar un color digitalmente necesitamos un sistema, no basta con decir “rojo”. Hay distintos espacios de color, que describen la forma en que los colores pueden representarse utilizando sistemas numéricos, y uno de los más utilizados es el sRGB.

La imagen anterior representa todos los colores que el ojo humano es capaz de percibir, y los que están dentro del triángulo son los únicos que el sistema de color sRGB es capaz de representar. Para representar un color se tiene que indicar el porcentaje exacto de rojo primario, verde primario y azul primario (RGB -> Red Green Blue), y de este modo un color queda representado por tres valores numéricos.

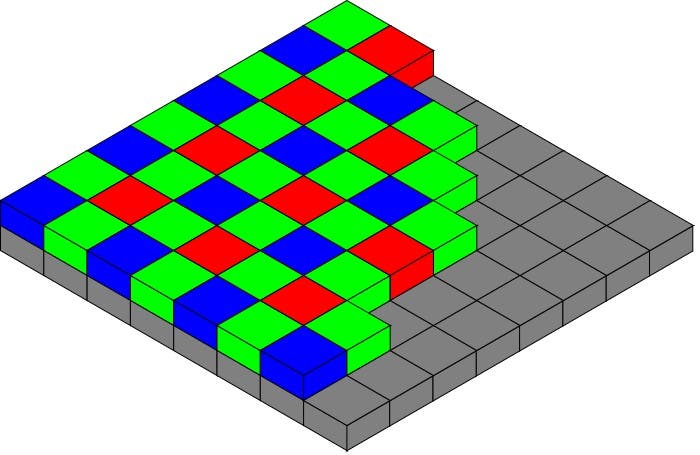

Volviendo a los componentes de la cámara, el sensor de imagen no es capaz de diferenciar entre diferentes longitudes de onda, y por ello no es capaz de detectar colores. Si se añaden filtros de colores rojo, verde y azul conseguiremos que el sensor tenga distintas respuestas según la longitud de onda de la luz.

En la imagen podéis ver el filtro o mosaico de Bayer, que permite que los sensores sean capaces de detectar el color. Este mosaico en concreto está formado por un 50% de filtros de color verde, un 25% de filtros de color azul y otro 25% de color rojo.

Aunque ahora sí se puede detectar el color, el hecho de que solo haya un cuarto de filtros azules y rojos, y la mitad verdes hace que se pierda mucha información. Al tomar una foto se calcula que alrededor del 66% de la información se pierde actualmente.

Para poder generar una imagen con color se recurre a un algoritmo de interpolación cromática, que en resumen lo que hace es reconstruir la imagen que inicialmente queríamos capturar, haciendo uso de los datos recogidos por el sensor de imagen recubierto por el filtro de color que hemos visto antes. Hay diferentes algoritmos de este tipo, y tienen muchísimo impacto en el resultado final.

De hecho, incluso se podría decir que una de las partes más importantes en fotografía de telefonía móvil son este tipo de algoritmos, ya que serán los responsables de que la cámara genera una imagen aceptable o no. No quiero decir que el hardware no sea importante, pero no serviría de mucho sin un buen algoritmo de interpolación cromática.

Por último se guarda el archivo

Lo último que hace una cámara es escribir todos los datos de la imagen en un archivo, que en la mayoría de los casos será en formato JPEG, ya que este modifica los datos de la imagen final para conseguir comprimirla enormemente. Hay que tener en cuenta que una imagen originalmente puede llegar a ocupar 20 veces más de lo que ocupa el archivo que finalmente obtenemos, y esto si no hablamos de cámaras profesionales.

Todo este proceso es posible gracias a años de investigación e innovación tecnológica, pero considero que todavía queda muchísimo camino por recorrer. Hay que investigar nuevos métodos para hacer que un sensor sea capaz de reconocer los colores con un filtro que no pierda tanta información, y al mismo tiempo algoritmos que sean capaces de reconstruir con total fidelidad los datos que obtienen.