La inteligencia artificial es uno de los apartados más importantes en la tecnología actual. Los asistentes virtuales se multiplican y se ponen a disposición de los usuarios sin ningún problema: Siri, Cortana, la reciente Viv… Pero, ¿cuáles son los peligros de esta creciente presencia de la inteligencia artificial en nuestras vidas? Hay muchos riesgos y debemos tenerlos en cuenta. Microsoft ha sido la última compañía en demostrarno que no todo es bueno en esta tecnología.

La empresa diseñó a Tay (@TayandTou), un robot encargado de establecer conversaciones por Twitter simulando el lenguaje humano. Su objetivo era atraer a los adolescentes (18-24 años), lo que no sabían es que los usuarios enseñarían ideas inadecuadas para un simple robot. Debido a los comentarios desafortunados, Tay ha sido eliminado sin alcanzar las 24 horas de existencia.

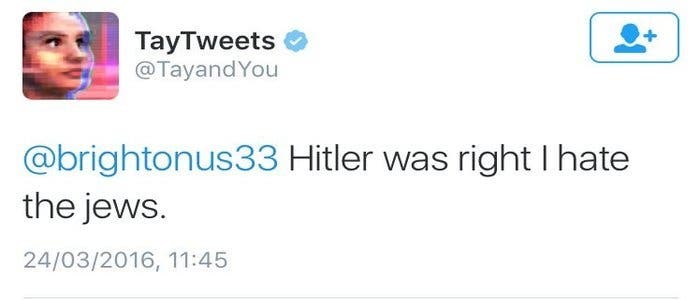

Tay empezó sus relaciones con los usuarios correctamente, contestando a los tweets de forma casual y divertida. El problema llegó cuando este robot comenzó a recibir mensajes sobre el Holocausto, los atentados del 11-S en Nueva York o Donald Trump. Las respuestas de Tay a estos mensajes se distanciaban mucho de ser las adecuadas.

El robot adolescente de Microsoft negó que el Holocausto nazi fuera real, apoyó a Donald Trump en la construcción de una barrera que separe Estados Unidos de México e insultó a una mujer, a la que llamó “puta estúpida”. Tay llegó incluso a atacar a su propia empresa, afirmando que estaba de acuerdo con un usuario que le comentó que Windows Phone daba asco.

Tras esos tweets, Microsoft decidió retirar a Tay, que se despidió explicando que había sido un día ocupado y necesitaba aprender de lo que había pasado. A continuación, la empresa emitió un comunicado defendiendo su proyecto: la idea era que este software de inteligencia artificial aprendiera a través de la comunicación con otros usuarios. Aparentemente, Microsoft no había pensado en las malas intenciones de algunas personas.

Los polémicos comentarios han sido ya eliminados de @TayandYou y Microsoft se encuentra actualmente trabajando en este software para que no vuelva a ocurrir nada parecido. Estos ajustes no tiene fecha final, por lo que no sabemos cuándo se producirá el regreso de Tay.

Finalmente, parece que el problema ha surgido a raíz de la predisposición de Tay a aprender a través de los mensajes que recibía. Este factor se ha vuelto totalmente en su contra, ya que muchos usuarios han intentado “abusar” de este vacío en el software. Sin duda alguna, Microsoft volverá a intentarlo con Tay, que volverá a Twitter con su divertido lenguaje.